正文:

WordPress 可以通过以下方法实现禁止用户访问 sitemap 并允许搜索引擎蜘蛛访问。Sitemap 是一个包含网站内所有链接的 XML 文件,它有助于搜索引擎蜘蛛快速找到和索引网站的各个页面。然而,有时网站所有者可能希望禁止用户访问 sitemap,只允许搜索引擎蜘蛛访问。为什么有人想要禁止用户访问 sitemap 呢?一种可能的原因是网站拥有一些不希望用户直接访问的页面或内容,只想通过搜索引擎蜘蛛进行索引。此外,有些网站所有者可能认为禁止普通用户访问 sitemap 能更好地控制网站的流量,并更好地保护敏感信息。那么如何实现禁止用户访问 sitemap 并允许搜索引擎蜘蛛访问呢?

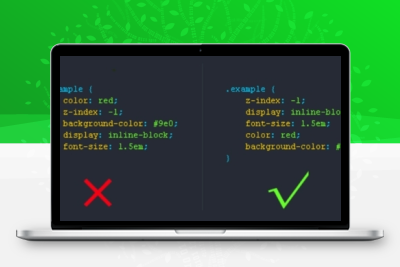

1 代码:

// 代码 1

function exclude_sitemap_from_non_admins()

{

// 检查是否是 sitemap 页面

if (strpos($_SERVER['REQUEST_URI'], '/sitemap.xml') !== false) {

// 检查是否是管理员

if (!current_user_can('administrator')) {

// 如果不是管理员,则禁止访问

header('HTTP/1.0 403 Forbidden');

exit;

}

}

}

add_action('init', 'exclude_sitemap_from_non_admins');

function allow_search_engines_to_access_sitemap()

{

// 检查是否是 sitemap 页面

if (strpos($_SERVER['REQUEST_URI'], '/sitemap.xml') !== false) {

// 允许搜索引擎访问

header('X-Robots-Tag: noindex, follow');

}

}

add_action('init', 'allow_search_engines_to_access_sitemap'); 2 代码

// 代码 2

<?php

// 管理员除外,禁止普通用户访问此文件

if ( ! current_user_can( 'manage_options' ) ) {

header( 'HTTP/1.0 403 Forbidden' );

exit;

}

// 允许搜索引擎蜘蛛访问 sitemap

function allow_robots_crawling() {

if ( ! is_admin() && is_sitemap() ) {

header( 'X-Robots-Tag: noindex,nofollow' );

}

}

add_action( 'wp_head', 'allow_robots_crawling' );

// 检查是否为 sitemap 页面

function is_sitemap() {

global $wp;

$current_url = home_url( add_query_arg( array(), $wp->request ) );

$sitemap_url = home_url( '/sitemap.xml' ); // 替换为你的 sitemap URL

return $current_url === $sitemap_url;

} 上述代码将禁止所有用户直接访问 sitemap.xml 文件,只允许搜索引擎蜘蛛进行访问。需要注意的是,上述方法并不能完全阻止用户访问 sitemap.xml 文件。由于搜索引擎蜘蛛在索引网站时会直接访问 sitemap.xml 文件,因此技术水平较高的用户仍然可以通过查看网页源代码或其他工具来找到并访问 sitemap.xml 文件。然而,对于大多数普通用户来说,上述方法已经足够有效地限制了对于 sitemap.xml 文件的访问。

结语:

综上所述,禁止用户访问 sitemap 并允许搜索引擎蜘蛛访问可以通过设置 robots.txt 文件和.htaccess 文件来实现。虽然无法完全阻止用户访问 sitemap.xml 文件,但对于大多数普通用户来说,上述方法已足够保护敏感信息和控制网站流量。

转载请注明:汇站网 » 禁止用户访问网站地图,但允许搜索引擎爬虫访问的代码

微信扫一扫

微信扫一扫 支付宝扫一扫

支付宝扫一扫

看看怎么样,感谢大佬分享。